11. November 2010

Das Web ist heute zu einem festen Bestandteil unserer aller Lebenswelt geworden – obwohl das noch vor 20 Jahren (fast) undenkbar war. Grund genug, einmal in den Weiten des Netzes nach Bewegtbildmaterial zu fahnden, das uns aus der Anfangszeit dieses digitalen Universums erzählen kann…

Weiterlesen »

19. Oktober 2010

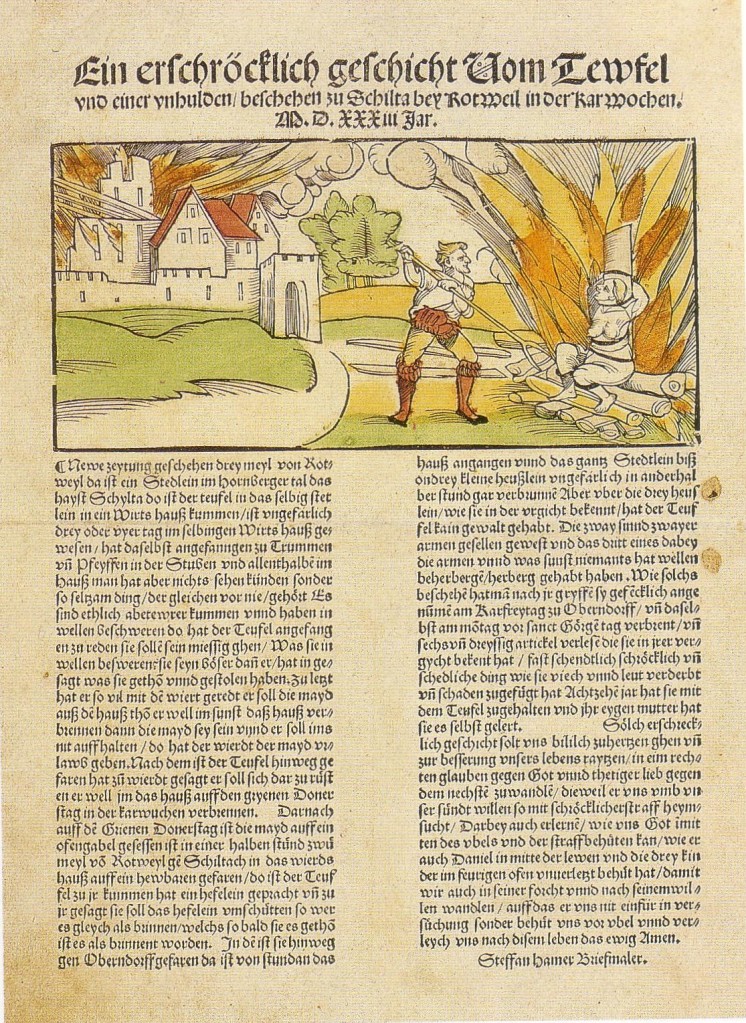

Gerade in Zeiten, in denen eine mediale Konfiguration vermeintlich abgelöst wird, macht es Sinn, einen kurzen Rückblick zu wagen. Daher an dieser Stelle eine kurze Geschichte der Printmedien, bevor wir uns wieder den aktuellen Entwicklungen um E-Books und Mobile Devices zuwenden… Initialpunkt für das Erstarken der Print- und Buchindustrie war die Institutionalisierung massenfähiger Druckverfahren in der Frühen Neuzeit, auch wenn es Gutenberg selbst keineswegs die preiswerte Vervielfältigung von Schriften ging (Bloom 2001): Zusammen mit seinem Investor Fust wollte er einen exklusiven Markt für handschriftlich ko- pierte Texte bedienen, der durch die Resultate der Skriptoren geprägt war. Ziel war es, mit einer »Schönschreibmaschine ohne Schreibrohr, Griffel und Feder« (Giesecke 2006: 134) kunstvolle und teuere Bücher zu produzieren. Dieses Ziel wurde durch die rekombinatorische Weiterentwicklung vorhandener Techniken (wie z.B. die Spindelpresse) erreicht (Hadorn/Cortesi 1985: 145).

(1533) Quelle: Wiki Commons

Ökonomen wie Beck (2005: 76) vermuten, dass Gutenberg durch die Urbarmachung dieser Techniken für den Druck die Reproduktionskosten für seine 180 Bibeln zwischen 1452 und 1454 mehr als halbieren konnte und schätzen seine Gewinnspanne auf über 200 Prozent. Das zog Nachahmer an und da die Buchdruckkunst zunächst frei von zünftischen Regeln war, breitete sich die Drucker schnell entlang der europäischen Handelswege aus. Schon Anfang des 16. Jh. befand sich die Branche mithin in ihrer ersten Krise, denn der eingegrenzte Absatzmarkt für repräsentative Drucke war übersättigt. Also nahmen die Druckwerkstätten zusätzlich illustrierte Flugblätter und Schriften ins Programm, die weit größere (auch nicht lesefähige) Rezipientenkreise erreichen konnten und – wie einige große Zeitungen auch noch heute – alle Themen behandelten, die ihren Absatz steigern konnten, so auch Übernatürliches, Kuriositäten und Klatsch (Stöber 2000: 43) … Weiterlesen!

1 Kommentar

11. Oktober 2010

Ab Oktober 2010 ist mein Buch “Neue Demokratie im Netz? Eine Kritik an den Visionen der Informationsgesellschaft” beim Transcript-Verlag verfügbar. Update: Mittlerweile ist auf der Vorstellungsseite des Buches auch eine Leseprobe verfügbar und hier gibt es den Personen- und Sachindex.

Weiterlesen »

30. September 2010

Jüngster Mitbewerber (auch) auf dem E-Reader-Markt ist das Apple iPad, welches sich stark von Konkurrenten wie dem Amazon Kindle (in Deutschland noch immer nicht im regulären Handel) oder dem Sony Reader unterscheidet. Unter anderem nutzt das iPad nicht, wie alle anderen E-Reader, ein hochauflösendes und von Sonnenlicht unbeeinflusstes E-Ink-Display mit Graustufendarstellung, sondern ein farbiges Multi-Touch-Display mit LED-Hintergrundbeleuchtung, was Amazon sogleich zu einem recht amüsanten vergleichenden Werbespot inspiriert hat:

[Nicht mehr verfügbar]

Weiterlesen »

14. September 2010

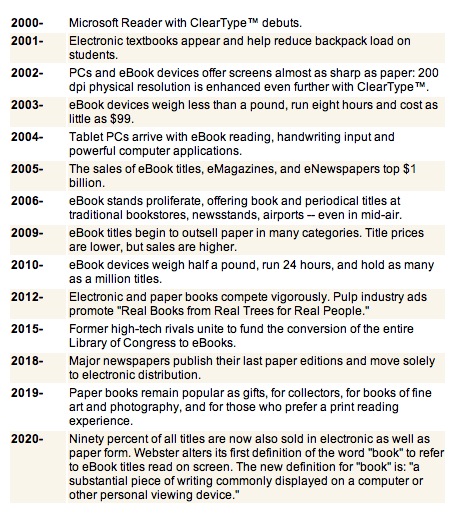

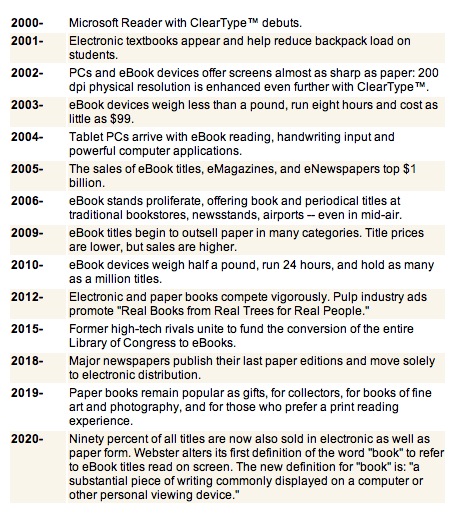

Prognosen sind kein einfaches Geschäft, keine Frage. Hin und wieder zeigt freilich ein Blick in die Vergangenheit, wie vorsichtig man mit weitreichenden Transformationshypothesen sein sollte: Microsofts Vorstellungen zum E-Book-Markt 2020 aus dem Jahre 2000 könnte jedenfalls nur noch wahr werden, falls sich die Entwicklungsgeschwindigkeit in den kommenden Jahren erheblich steigern sollte (siehe Screenshot)…

Solche übersteigerten Visionen werden ja allgemeinhin gerne wieder vom Netz genommen, via Web Archive bleiben sie allerdings der Nachwelt erhalten.

3 Kommentare

2. September 2010

“Plötzlich kommt das elektronische Buch in vielen Versionen. Zusammen führen sie zu einer gewaltigen Veränderungen in den Beziehungen zwischen Autoren, Lesern, Verlagen, Buchhandlungen, Bibliotheken und Rezensenten, also der gesamten Welt des Buches oder einfach der ganzen Welt. Das herkömmliche Buch mit den Seiten aus Papier kann bereits auf dem Weg sein, ein nostalgisches Objekt zu werden, das vornehmlich antiquarisches Interesse auf sich zieht”.

Dieser Artikel-Teaser stammt nicht etwas aus dem Jahre 2010, sondern wurde 1998 in Telepolis veröffentlicht. Und tatsächlich, wir haben es schon beinahe vergessen: Ende der 1990er Jahre sollte unsere Gesellschaft nach Vorstellung vieler digitaler Evangelisten schon einmal durch die E-Books umdefiniert werden. Hin und wieder lohnt sich also der Blick zurück, um festzustellen, dass manche Innovationen und die aus ihnen entstehenden Hypes gar nicht so neu sind, wie es zunächst scheint.

Hier ein kurzer Überblick über die Geschichte des E-Books bzw. der E-Reader:

- “Mona Lisa Overdrive” von William Gibson wurde 1988 auf Floppy-Disk publiziert und war somit das erste elektronische Buch, das sich käuflich erwerben ließ.

- Bereits 1990 bzw. 1993 brachte Sony den Data-Discman bzw. den Bookman heraus und vermarktete die Geräte als “Electronic Book Player”. Als Datenmedien dienten CD-Roms mit 8cm Durchmesser. Das Display verfügte über eine Auflösung von 256×160 Pixeln (S/W). Der Packung beigelegt waren elektronische Versionen des Bertelsmann Universal-Lexikons und des Langenscheidts Taschenwörterbuchs Englisch. Kritikpunkte und Gründe für die mangelnde Verbreitung waren das zu kleine Display, geringe Batterielaufzeiten und eine mangelhafte Suchfunktion.

- 1998/99 wurde das Rocket eBook der Firma NuvoMedia geboren: Etwa 4000 Buchseiten passten auf den 4 (später 16) Megabyte großen Speicher des Geräts. Das Display hatte eine Auflösung von 480×320 Bildpunkten (SW), der als revolutionär eingestufte Reader (s.o.) war für gut 650 D-Mark zu haben. Die Reaktionen 5 Monate nach Markteinführung waren indes eher verhalten: “Nach 5 Monaten regelmäßiger Lektüre steht zumindest eines fest: Man kann auf dem Gerät problemlos längere Texte für längere Zeit lesen und der Kauf hat mich, trotz des happigen Preises von 675 Mark, nicht gereut – auch wenn die aktuelle Materialisierung meines Traums bestenfalls ein leidiger Kompromiss ist. Anders gesagt: Das Rocket E-Book ist – so, wie es derzeit ist – ein ziemlicher Murks” (Damaschke in Die Zeit 46/2000).

- Im Jahr 2000 wurden NuvoMedia sowie SoftBookPress, ein anderer E-Reader-Hersteller von Gemstar übernommen, die kurz darauf mit dem REB 1100 und REB 1200 zwei runderneuerte Reader anbot. Im Jahr 2001 folgte der GEB 2200, ein Gerät, das ca. 1 Kilogramm schwer war, über ein Farbdisplay mit 640×480 Pixeln Auflösung, 8 Mbyte internen Speicher, einen Slot für Speicherkarten, ein Modem sowie eine Ethernet-Schnittstelle verfügte, so dass direkt auf den Online-Store des Unternehmens zurückgegriffen werden konnte, der ca. 1000 deutschsprachige Titel bereit hielt. Im Kaufpreis von ca. 650€ (später deutlich billiger) war ein sechwöchiges Abo des elektronischen Spiegels und ein vierwöchiges Abo der Financial Times inbegriffen.

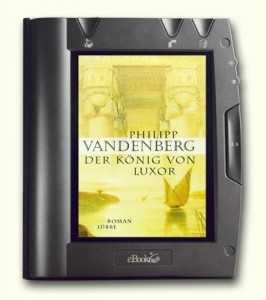

- Die Bemühungen von Gemstar fruchteten freilich nicht: Ende 2003 stellte das Unternehmen den Verkauf seiner Geräte weltweit ein. Anderen Firmen ging es ähnlich. Danach folgten weitere Versuche von Sony (LIBRIE EBR-1000EP 2004, erstmals mit E-Ink-Technologie), ab 2007 wagte sich die Philips-Tochter iRex Technologies mit dem iLiad auf den Markt, Amazon launchte 2007 den Kindle und Sony präsentierte 2008 den Sony-Reader.

Der GEB 2200 E-Reader

Mit all diesen Geräten waren wichtige technische, aber auch konzeptionelle Weiterentwicklungen verbunden: Die Bedienung, der Lesekomfort und der Bezug von E-Books wurde stetig verbessert. Allein: Bislang konnten die E-Reader den Buchmarkt kaum revolutionieren, jedenfalls nicht in vergleichbarem Maße, wie die digitale Technik die Strukturen in anderen Bereichen umgekrempelt hat. Seit einigen Monaten nun ist das Apple iPad auf den Markt – mit angeschlossenem iBooks-Store, Touch-Screen, Umblätter-Animationen und allem Pipapo. Sicherlich ist das Gerät in vielerlei Hinsicht eine Bereicherung und taugt auch zum gelegentlichen Lesen. Ob es allerdings den Buchmarkt einschneidend verändern wird, steht noch in den Sternen, auch wenn der Hype um das Gerät durchaus schon mit dem E-Book-Hype aus den 1990er Jahren vergleichbar ist.

So zieht der Spiegel in einem aktuellen Bericht die Bilanz, dass der E-Book-Boom zumindest in Deutschland weiter auf sich warten lassen wird: Gerade einmal 20% der Deutschen wissen, was ein E-Reader ist. Die Durchdringung des Marktes lasse auf sich warten, auch weil das Inhaltsangebot noch immer zu klein und vor allen Dingen vollkommen überteuert sei. Das allerdings wurde schon zu Zeiten des Rocket eBook bzw. des GEB 2200 angemahnt (vgl. Manager Magazin 2001). Die Preispolitik lässt sich freilich ändern und das digitale Leseerlebnis hat sich mit jeder Neuentwicklung kontinuierlich verbessert. Zentrale Mankos bleiben aber neben dem fehlenden haptischen Erlebnis: Ein E-Book kann ich nicht gefahrenfrei an den Strand oder in den Park mitnehmen: Wenn ein klassisches Papierbuch nass oder dreckig wird, macht das wenig. Falls es geklaut wird, habe ich in den meisten Fällen weniger als 10 € verloren. Möchte ich das Buch einer Freundin oder einem Freund leihen, kann ich es ihm ohne Kopier- oder Konvertierungsaufwand mitgeben…

3 Kommentare