Kurze Geschichte der künstlichen Intelligenz (1)

Jan-Felix Schrape | 7. Dezember 2024Die Geschichte der modernen KI (siehe Tabelle) beginnt mit dem Logiker, Analytiker und Mathematiker Alan Turing (1912–1954), der mit seinem »Turing-Test« die heutige Vorstellung von künstlicher Intelligenz maßgeblich geprägt hat. Er selbst nannte seinen Test »Imitation Game« und bezog ihn auf die Antworten einer Maschine im Dialog mit einem oder mehreren Menschen: Wenn das kommunikative Verhalten einer Maschine nicht mehr von menschlichem Verhalten unterscheidbar erscheint, sollte von maschineller Intelligenz gesprochen werden. Eine Maschine wäre aus dieser Perspektive folglich »intelligent«, sobald sie ihr Gegenüber erfolgreich täuschen kann.

Der Begriff »künstliche Intelligenz« tauchte erstmals in dem Förderantrag für die Dartmouth Conference auf. Dort erörterten zu dieser Zeit führende Mathematiker und Informatiker für mehrere Wochen, »how to make machines use language, form abstractions and concepts, solve kinds of problems now reserved for humans, and improve themselves« (McCarthy et al. 1955).

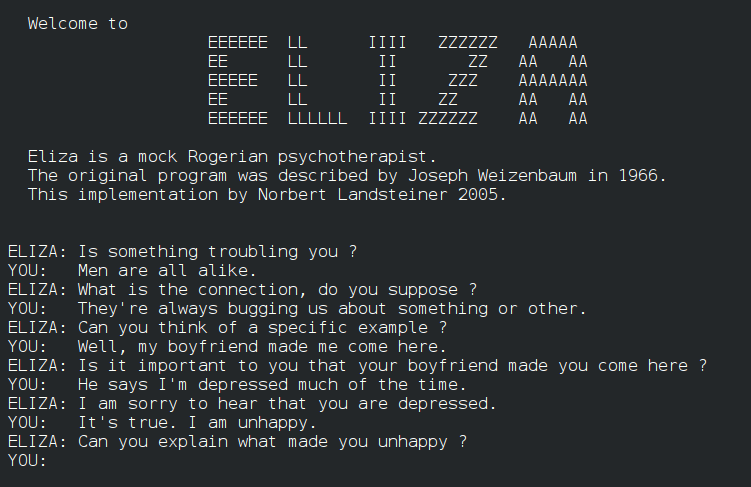

Einen ersten öffentlichen Hype erlebte das Thema ab 1966 mit dem von Joseph Weizenbaum entwickelten Computerprogramm ELIZA, das in einer textbasierten Unterhaltung unterschiedliche Gesprächspartner simulieren kann, indem es auf Schlüsselwörter reagiert, falls diese in seinem Thesaurus zu finden sind. In Presse, Funk und Fernsehen wurde vor allem die Rolle von ELIZA als Psychotherapeutin aufgegriffen. Auf die Eingabe »Ich habe ein Problem mit meiner Mutter« lautete eine Antwort zum Beispiel: »Erzählen Sie mir mehr über Ihre Familie«.

Weizenbaum wollte mit ELIZA die Möglichkeiten der Computer-Kommunikation ausloten und vor Augen führen, dass ein echter Dialog zwischen Mensch und Maschine letztlich unmöglich bleibt. Tatsächlich bewirkte sein Experiment das Gegenteil: Zum einen begannen einige Testpersonen damit, dem Computerprogramm Gefühle zuzuschreiben. Zum anderen wurden in der Öffentlichkeit große Erwartungen an die zukünftigen Potenziale von KI geweckt – so beispielsweise auch die Annahme, dass sich Psychotherapie in naher Zukunft automatisieren ließe.

Weizenbaum (1978: 311) selbst war von diesen Debatten erschüttert, weil er ja wusste, nach welch einfachen Regeln sein Programm funktionierte, und warnte einige Jahre später davor, »dass unsere Gesellschaft sich zunehmend auf Computersysteme verlässt, die […] das Verständnis derjenigen übersteigen, die mit ihnen arbeiten«.

| 1950 | Turing-Test | Alan Turing entwickelt einen Test zu der Frage, ob Maschinen denken können. |

| 1956 | Dartmouth Conference | Das Forschungsgebiet und der Begriff der künstlichen Intelligenz werden definiert. |

| 1966 | ELIZA Chatbot | Joseph Weizenbaum veröffentlicht den Prototyp für KI-Chatbots. |

| 1972 | Expertensysteme; Industrierobotik | Erste anwendungsorientierte Expertensysteme werden für den medizinischen Bereich und die Industrie entwickelt. |

| 1986 | NETtalk | Die Generierung gesprochener Sprache wird möglich. |

| 1996 | IBM Deep Blue | Der Schachcomputer Deep Blue besiegt den damaligen Schachweltmeister. |

| 2009 | Deep Learning | Die Analyse komplexer Daten durch künstliche neuronale Netze wird praxistauglich. |

| 2010 | IBM Watson | Das Computerprogramm Watson gewinnt in der US-Quizshow »Jeopardy!«. |

| 2011 | Virtuelle Assistenten | Programme wie Apple Siri können auf natürlich gesprochene Sprache reagieren. |

| 2022 | Generative KI | ChatGPT und andere Systeme können Inhalte und Daten erzeugen. |

Mitte der 1970er-Jahre zeichnete sich ab, dass viele Entwicklungsziele im Bereich der künstlichen Intelligenz auf absehbare Zeit unerreichbar bleiben würden. Das führte zu einem jahrzehntelangen »KI-Winter«, in dem das öffentliche Interesse und die Förderung entsprechender Entwicklungsprojekte stark zurückgingen. Auf den Feldern der Industrierobotik und der Expertensysteme gab es in dieser Zeit zwar durchaus vielfältige Fortentwicklungen – aber in den meisten Fällen eben nicht mehr unter der Wortmarke »künstliche Intelligenz«.

Das änderte sich erst wieder nach der Jahrtausendwende, als es ab 2009 gelang, maschinelle Lernverfahren durch den Einsatz künstlicher neuronaler Netze zu effektivieren, die sich in hochregulierten Verfahren mit großen Datensätzen trainieren lassen und in der Lage sind, abstrakte Merkmale aus diesen Daten zu extrahieren (»Deep Learning«). Auf diese Weise können moderne KI-Systeme nun auch Aufgaben bewältigen, die Menschen intuitiv lösen können, sich aber nur schwer durch formale Regeln beschreiben lassen – darunter das Erkennen von Gesichtern und unscharf artikulierter Sprachinhalte oder das Verstehen von Gesprächen in lauter Umgebung.

Darauf aufbauend stellte Google 2017 die Transformer-Architektur für die Verarbeitung natürlicher Sprache und maschinelles Lernen vor, die auf eine rekurrente Struktur verzichtet und einen »weich« gewichteten Aufmerksamkeitsmechanismus einsetzt, der die kognitive Aufmerksamkeit des Menschen nachahmt, um die wesentliche Bedeutung und Sinnstruktur in einem gegebenen Kontext zu erkennen. Diese Fortschritte bilden die Grundlage für Large Language Models wie GPT (von OpenAI) oder Gemini (von Google).

Der Preis dafür ist, dass sich die Outputs dieser Systeme selbst mit hohem Aufwand kaum mehr erklären oder rekonstruieren lassen: Künstliche neuronale Netze arbeiten mit Millionen von internen, von außen nicht einsehbaren Parametern, die das System in Milliarden von Rechenoperationen auf die Trainingsdaten abstimmt.