Querverweis: My syllabus on Artificial Social Intelligence (Silver Linings)

25. November 2025Daniel Silver, Soziologieprofessor an der University of Toronto Scarborough, hat den Syllabus zu seinem vielversprechenden Graduiertenseminar »Beyond the Singularity: Building Artificial Social Intelligence« auf Substack geteilt. Für die einzelnen Sitzungen hat er ein breites Portfolio von Lesestücken an der Schnittstelle von Soziologie, Kognitionswissenschaft, Informatik und Digitalisierungsforschung zusammengestellt, die sich dort auch gebündelt abrufen lassen. Darum geht es:

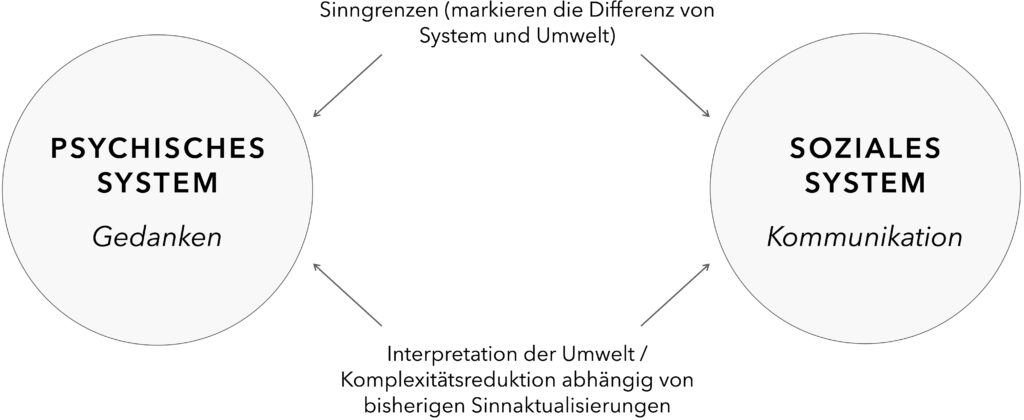

The ambition driving much artificial intelligence is to build a god: a singular, all-knowing super-intelligence. This seminar begins from the proposition that this goal is not only misguided but also ignores a fundamental proposition of classical sociology: intelligence is social. We will advance the proposition that true superintelligence (often referred to as ASI), should it ever exist, will not be a monolithic entity, but a fundamentally social and distributed system.

We will seek to dislodge the prevailing image of Artificial General Intelligence (AGI) – a gigantic individual mind – for a richer and more generative concept: Artificial Social Intelligence (ASI). We will explore the idea that the future of AI lies in networks of intelligent agents that must learn to creatively and situationally understand, coordinate, and sometimes compete with each other and with us.

While computer science often approaches this topic through Multi-Agent Systems (MAS), our focus is distinct and complementary; we will use classical sociology as a launching point to reimagine AI, focusing on the underlying capabilities and orientations that make multi-agent interaction possible and more or less effective.